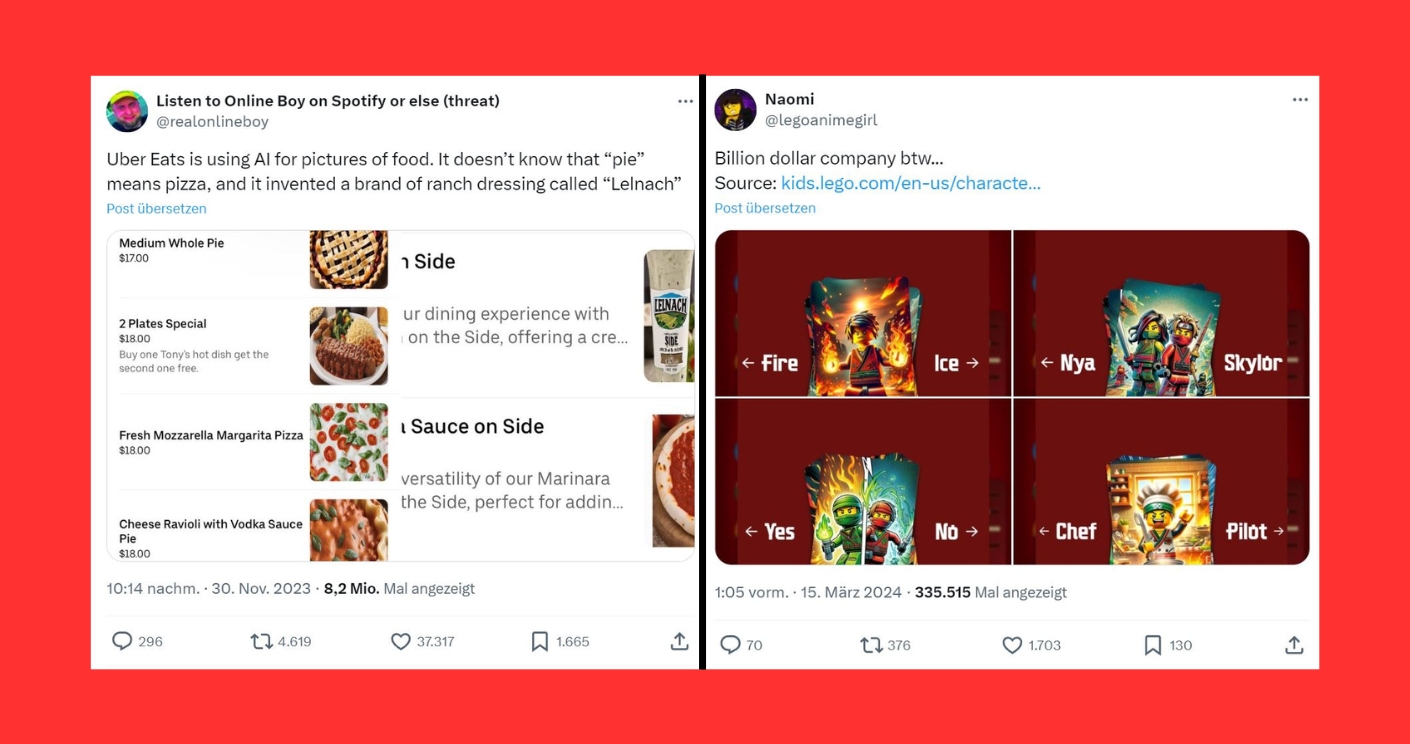

Im New Yorker Slang steht „Pie“ für Pizza. Für Einheimische ist das selbstverständlich, für die künstliche Intelligenz von Bildgeneratoren offenbar nicht. Pech für den Bestellservice „Uber Eats“, der in seiner App KI-generierte Bilder für die Speisekarte eines lokalen Pizza-Restaurants verwendete: Statt Pizzen zeigten die Bilder dem eigentlichen Wortsinn nach (groteske) Kuchen und Pasteten. Da das Generieren von Text für die Bild-KI noch eine Herausforderung ist, waren zudem die abgebildeten Soßenflaschen unsinnig beschriftet. Ein Kunde postete Screenshots der missglückten Speisekarte auf der Plattform X, der Thread ging viral. Nicht nur die Marke „Uber Eats“ erlitt Schaden, auch das Image des Pizza-Restaurants wurde beschädigt.

Wann sind KI-Bilder sinnvoll?

Die korrekte Darstellung von gelieferten Produkten ist das eine. Problematisch wird es, wenn Rechte verletzt werden. Der Spielzeughersteller Lego etwa experimentierte für ein Online-Quiz zu seiner „Ninjago“-Reihe mit KI-generierten Bildern. Eines davon enthielt nicht-lizenzierte Inhalte. Nach Kritik in den sozialen Medien entfernte Lego die Bilder wieder, die Website mit dem Quiz ist inzwischen nicht mehr abrufbar.

Diese Fälle zeigen nicht nur, dass der prüfende Blick eines Menschen eine Veröffentlichung der KI-Fehldarstellungen hätte verhindern können. Sondern auch, dass wir uns grundsätzlich fragen müssen: Setzen Unternehmen das Vertrauen ihrer Kund:innen und Stakeholder mit KI-generierten Produktbildern leichtfertig aufs Spiel?

Ob bei Lego oder auch bei X-Box: Wenn Marken KI-Bilder in ihrer Kommunikation verwenden, kritisieren Nutzer:innen immer wieder, dass Unternehmen es sich zu einfach machten. Sie fordern mehr Respekt – für die Kundschaft, aber auch für die an der Produktentwicklung beteiligten Designer:innen. „Ninjago“-Mitschöpfer Tommy Andreasen brachte die Kritik in einem X-Post auf den Punkt: „Kunst sollte von Künstlern gemacht werden.“ Inzwischen haben erste Unternehmen ihre Agenturverträge um Klauseln ergänzt, die den Einsatz von KI begrenzen sollen.

Wo beginnt und endet KI?

In Deutschland stimmen Agenturen den Einsatz von KI-Tools meist mit ihren Auftraggebern ab. Doch die Abgrenzung wird immer schwieriger. KI ist schon jetzt ein wichtiger Bestandteil von Software zur Bildbearbeitung wie Adobe Photoshop. Features wie „Generatives Erweitern“ (Outpainting), „Generative Füllung“ (Inpainting) und „Objektauswahl“ sind eine große Hilfe, wenn ein Bestandsbild für unterschiedliche Kanal-Formate angepasst oder zum Beispiel ein überquellender Mülleimer aus dem spontanen Team-Foto entfernt werden soll.

Auch die „Neural Filters“ in Adobe Photoshop erleichtern die Bearbeitung bereits vorhandener Bilder enorm: In Sekunden glätten sie die irritierte Haut des Vorstandsvorsitzenden oder beseitigen störende Jpeg-Artefakte. Dafür generiert die KI laut Adobe „neue kontextabhängige Pixel, die nicht im Originalbild vorhanden sind“. Den Einsatz generativer KI deshalb grundsätzlich auszuschließen, hieße aber auch, auf solche Arbeitserleichterungen zu verzichten. Wollen wir das? Oder geht es nicht eher darum, den Einsatz dieser Tools sinnvoll abzugrenzen und transparent zu machen?

Motor für Neues

Gerade für den Ideation-Prozess, also die Ideenbildung und -findung, für Experimente und das Erstellen von Moods eröffnet uns bildgenerierende KI ganz neue Möglichkeiten.

David Holz, CEO von Midjourney, beschrieb das in einem Interview mit „The Verge“ so: „Jedes Mal, wenn man die KI bittet, ein Bild zu erstellen, erinnert oder weiß sie nicht wirklich, was sie jemals zuvor gemacht hat. Sie hat keinen Willen, keine Ziele, keine Absicht und keine Fähigkeit, Geschichten zu erzählen. Das Ego und der Wille und die Geschichten – all das sind wir. Sie ist wie ein Motor. Nicht der Motor muss irgendwohin, sondern die Menschen müssen es.“

Lost in Prompting

Zugegeben, diese neue Art, den Bilderstellungsprozess zu steuern, ist faszinierend. Mit anhaltender Begeisterung ringen wir den Tools manchmal über mehrere Tage mittels ungezählter Prompt-Iterationen spezifische Stile ab. Das Ziel: Ergebnisse, die sich möglichst von der KI-typischen Hochglanz-Ästhetik abheben. Manchmal reicht dafür schon ein Stichwort wie „press photo“.

Aber oft ist ein strategischer Ansatz nötig: Was ist das Thema? Wie sollten Hintergrund, Details, Ausdruck, Haltung, Stil und so weiter aussehen? Wie verhalten sich die Elemente zueinander?

Als Effizienz-Tool funktioniert KI oft nur, wenn User Abstriche bei der Qualität oder dem Motiv in Kauf nehmen. Ist ein klar definiertes Ergebnis gewünscht, kann das Prompten einige Zeit in Anspruch nehmen. Doch je besser man in der Lage ist, die Sprache der Bilder in Prompts zu übersetzen, umso besser sind auch die Ergebnisse.

Designer:innen sind hier klar im Vorteil. Sie beherrschen die Klaviatur von Bildaufbau, Licht und Farben. Sie wissen, wie sie auf Basis ihrer Skills eine bildgenerierende KI zu Höchstleistungen antreiben können und worauf es ankommt, wenn es gilt, Bilder im Rahmen des Corporate Design zu erschaffen und das Image der Marke authentisch zu interpretieren.

Wertschätzung für die Leistung menschlicher Künstler:innen hat auch Lego nach der Kritik an seinen KI-Bildern zum Ausdruck gebracht und sich entschuldigt. Das KI-Experiment habe nicht die üblichen Freigabeverfahren durchlaufen, sagte das Unternehmen einer US-Newsseite. An künstlicher Intelligenz will das Unternehmen aber grundsätzlich festhalten.

Dieser Beitrag ist Teil der Themenreihe „How-to GenAI“, die sich mit dem Einsatz von generativer künstlicher Intelligenz in der Unternehmenskommunikation beschäftigt. Regelmäßig erscheinen an dieser Stelle Beiträge wechselnder Autor*innen zu theoretischen und praktischen Aspekten.